Abstract

Deep Image Prior(DIP)表明,一些网络架构本质上倾向于在抵抗噪声的同时生成平滑图像,这种现象被称为 Spectrl Bias。

图像去噪是该属性的自然应用。虽然使用DIP消除了对大型训练集的需求,但需要克服两个通常相互交织的实际挑战:结构设计和噪声拟合。

由于对结构选择如何影响去噪结果的理解有限,现有的方法要么手工制作,要么从广阔的设计空间寻找合适的结构。

在这项研究中,我们从频率的角度证明,未学习的上采样是 DIP 去噪现象背后的主要驱动力。

这一发现导致了为每张图像确定合适结构的简单策略,而无需费力搜索。

广泛的实验表明,估计的架构实现了优于现有方法的去噪结果,参数减少了95%。

由于这种少的参数量,由此产生的架构不太容易发生噪声拟合。

Investigation and Method

The importance of upsampling

我们首先确定了影响DIP去噪性能的核心架构组件。为此,我们通过从典型的编码器解码器架构[33]中删除编码器来分析仅解码器架构,因为解码器是重建最终图像的最小需求。我们的分析基础模型是一个6层卷积解码器(Conv-Decoder[10]),除最后一个回归层外,每层有128 3 × 3过滤器,然后是批标准化、ReLU激活和向上采样。我们进一步简化了设置,将空间滤波器替换为像素级1×1滤波器,构建了一个名为MLP解码器的非卷积变体。

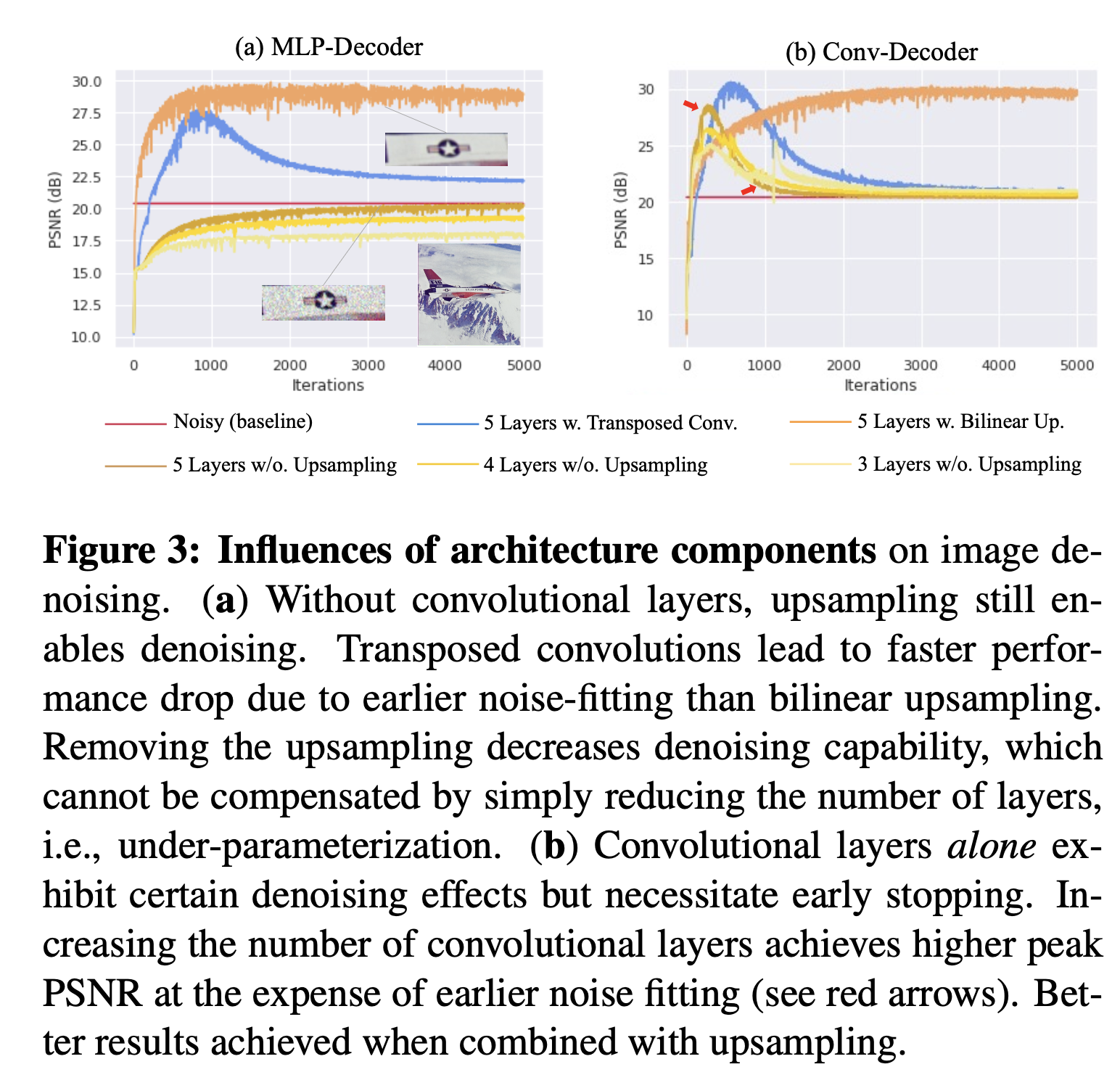

MLP-解码器的结果如图3(a)所示,表明上采样发挥了至关重要的作用。去除上采样会导致降噪性能显著下降,而这种下降不能仅通过增加网络规模以解决欠参数化的问题来补偿。这适用于其他任务,如超分辨率(Suppl.A)。图3(b)显示,与像素滤波器相比,仅可学习的空间滤波器也可以实现去噪,再次确认卷积层的频率偏差[3]。然而,随着网络规模的增加和噪声拟合的发生,效果会消失。卷积层与上采样一起取得了更好的结果,表现为更高的峰值PSNR和更长的去噪效应。

Discussion. 这些结果表明,适当的上采样操作对于有效的网络图像先验至关重要,仅靠参数化不足是不够的。不同的上采样操作会导致不同程度的去噪效应:转置卷积[25]往往比双线性上采样更快地适应噪声,因此需要 early stopping。在下一节中,我们从信号处理的角度调查这些上采样操作的行为,以深入了解它们对去噪性能的影响。

Spectral effects of upsampling

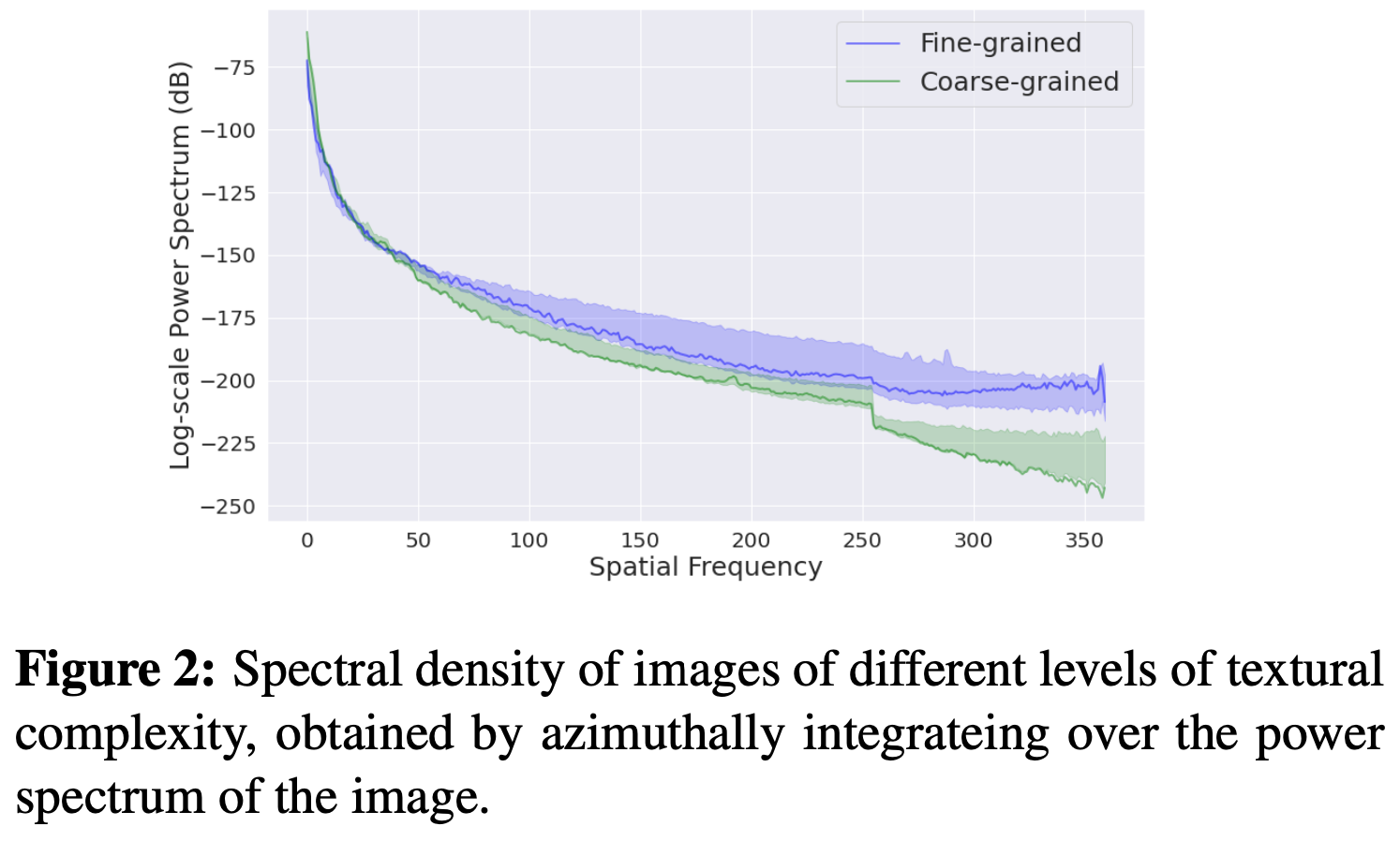

Discussion. 这些结果使我们得出结论,具有固定 LPF 的上采样器是 DIP 偏向平滑图像(即高频内容减少)的去噪效应的关键,这与自然图像的频率统计学非常一致(图2)。可能是由于去噪性能和持久性之间的良好平衡,双线性上采样已在各种应用的DIP模型中被广泛采用[33、15、13、16]。

Interactions with other architecture elements

在确定上采样的重要性后,我们现在将考虑它如何与其他常见的架构元素相互作用,以影响最终输出。

Convolutions + non-linearity. 理想的上采样不会修改信号表示,而只会扩展后续层的频谱,以添加新的频率内容。卷积后跟ReLU等非线性,是唯一能够引入任意高频的操作[19]。增加层数(深度)或通道(宽度)增强了产生新高频的能力,正如[26]的理论和经验证明的那样。

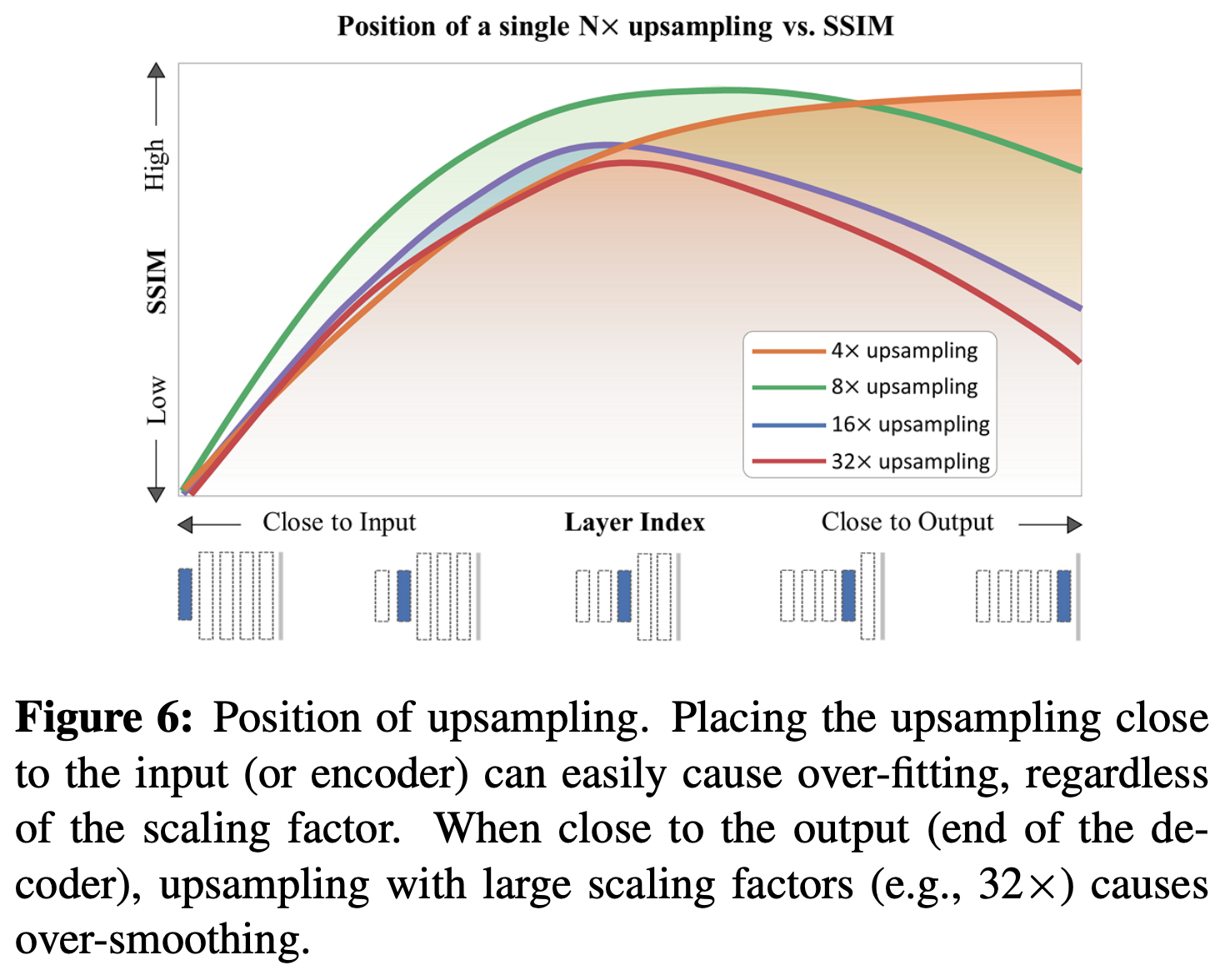

直观地说,使用过多的层或通道可以加速对细节和噪音的学习。然而,这些影响可以通过层之间的固定上采样操作来减弱。如图5所示,当使用较少的上采样操作(即较浅的网络)时,增加网络宽度会增加导致对更简单图像过拟合的趋势,同时使更复杂的图像受益。增加上采样操作的数量(即更深的网络)可以通过更强的衰减来缓解过拟合,但会导致细粒度图像的输出模糊。仅增加上采样因子而不添加更多层可能会使输出更加模糊(图6)。换句话说,最终输出取决于层生成高频与上采样操作引起的信号衰减之间的平衡。

Skip connections 编码器和解码器之间的跳连连接通常使得设计空间变得复杂[6]。尽管它们并不直接负责去噪,但是它们可能会降低有效的上采样率,使得深层网络的性能与较浅层的网络相似,即,导致对高频复制信号的抑制较小。这一发现在一个大规模实验中得到验证,该实验包括7424种架构(补充材料D)。如图5(b)所示例证的那样,跳跃连接显著地改善了由相同深层网络引起的过度平滑问题。总的来说,与较浅层网络相比,跳跃连接对深层网络的影响更加显著,这一点在图5(b)中观察到的深度≤3时的偏差较小中得到了证明。

Practical application to architectural design

基于上述发现和分析,我们认为无需广泛搜索即可估计每张图像的有效架构。假设每个解码器层之后都有一个2×双线性上采样层,我们的策略如下:

Depth estimation. 我们已经展示了增加深度倾向于过度平滑输出,对于细粒度图像影响比粗粒度图像更大。对于细粒度图像,我们有三个选择:a) 在深层网络中增加更多的跳跃连接;b) 简单地使用浅层网络;c) 保留所有层但减少上/下采样层。我们推荐对于仅有解码器的架构使用c,因为它们已经欠参数化;对于 U 型网络这很容易导致过拟合(见图6)。我们发现在权衡良好性能和需要 early stopping 之间,b通常比a更好,特别是在更高级别的噪声下,正如我们的结果部分所展示的。这同样适用于粗粒度图像,因为它们对深度不敏感。更具体地,我们发现对于两种类型的图像,一个2-level 的 U 型网络就足够了(见补充材料D)。

Width estimation. 宽度对于在避免过拟合的同时学习足够细节,尤其对于浅层网络(信号衰减较少)来说至关重要。我们发现宽度的设置需要根据图像的纹理复杂性来确定:细腻度较高的图像需要每层更多的通道,反之亦然。为了进一步验证这一点,我们将宽度估计视为一个分类问题,并训练了三个具有纹理特征作为输入的SVMs [8],以将图像分类为三种宽度选择{32, 64, 128}。请注意,这些宽度是根据本研究中使用的数据集经验性选择的,并不意味着适用于所有情况,但调整其他图像应该很直接。分类结果和分析请参见第4.4节。

Image scoring. 为了更稳健地分类图像纹理,我们提取了空间和频率特征,并训练了决策树[22]进行特征选择。我们使用经典的灰度共现矩阵(GLCM)[14]从每张图像中推导出空间纹理特征。

-

Previous

【TPAMI 2023】What Makes for Good Tokenizers in Vision Transformer? -

Next

【ICCV 2023】CTM-SCI:Unfolding Framework with Prior of Convolution-Transformer Mixture and Uncertainty Estimation for Video Snapshot Compressive Imaging