Abstract

单图像超分辨率(SISR)是将给定的低分辨率(LR)图像重建为高分辨率(HR)图像,这是一个病态问题,因为一个LR图像对应多个HR图像。

近年来,基于学习的SISR方法的性能大大超过了传统的方法,但面向PSNR的方法、GAN驱动的方法和基于Flow的方法分别存在过平滑、模式崩溃或模型占用过大的问题。

为了解决这些问题,这篇文章提出了一种新的单图像超分辨扩散概率模型(SRDiff),这是第一个基于扩散模型的单图像超分辨模型。

SRDiff 优化一个在数据似然的变分下限的变体,通过马尔可夫链将高斯噪声逐渐转化为以LR输入为条件的超分辨率(SR)图像,从而提供多样化和真实的SR预测。

此外,在整个框架中引入残差预测,以加快收敛速度。

在面部和通用基准测试(CelebA和DIV2K数据集)上的广泛实验表明:

1) SRDiff可以在只提供一个LR输入的情况下,生成具有丰富细节和最先进性能的多样化SR结果

2) SRDiff易于训练

3)SRDiff可以进行灵活的图像处理,包括隐空间插值和内容融合。

Introduction

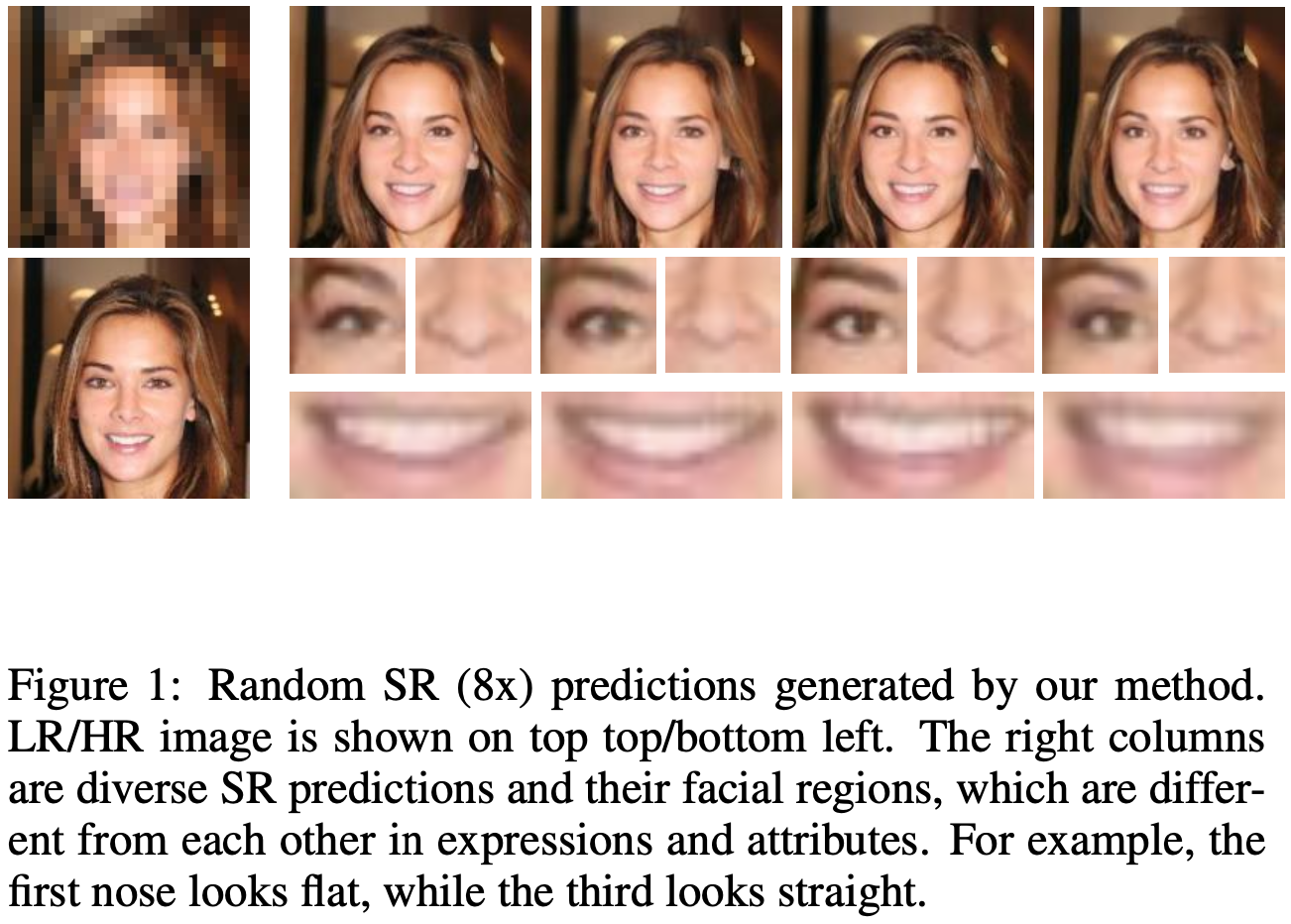

多年来,单图像超分辨率(SISR)因其在物体识别、遥感、监控等计算机视觉中的广泛应用而备受关注。SISR旨在从低分辨率(LR)图像中恢复高分辨率(HR)图像,这是一个病态的问题,如图1所示,多个HR图像可以退化为一个LR图像。

为了建立HR和LR图像之间的映射,出现了许多基于深度学习的方法,可以分为三种主要类型:面向PSNR、GAN驱动和基于 FLOW 的方法。面向PSNR的方法使用基于简单分布假设的损失进行训练(例如,L1的Laplacian 和 L2的Gaussian),并实现了出色的PSNR。然而,这些损失往往会将SR结果推向几个可能的SR预测的平均值,导致图像过于平滑和高频信息丢失。解决过度平滑问题的一个突破性解决方案是GAN驱动的方法,它结合了内容损失(例如L1和L2)和对抗性损失,以获得具有更好感知质量的更清晰的SR图像。然而,GAN驱动的方法很容易陷入模式崩溃,这导致单个生成的SR样本没有多样性。此外,基于GAN的训练过程不容易收敛,需要一个额外的判别器,其不用于推理。基于 Flow 的方法直接解释了可逆编码器的病态问题,该编码器将HR图像映射到以LR输入为条件的流空间。基于 Flow 的方法在负对数似然损失的情况下进行了训练,避免了训练不稳定性,但由于保持隐空间和数据之间的双射的强大架构约束,占用空间非常大,训练成本高昂。

最近,在图像合成和语音合成中成功采用扩散概率模型(简称扩散模型)见证了扩散模型在生成任务中的力量。扩散模型使用马尔可夫链,通过在扩散过程中逐渐添加噪声 $\epsilon$,在简单分布(例如高斯)中将数据 $x_0$ 转换为隐变量 $x_T$,并在每个扩散步骤中预测噪声 $\epsilon$,通过学习的逆过程重新复原数据 $x_0$。通过优化变分下界的变体来训练扩散模型,这既高效又避免了GAN遇到的模式崩溃。

这篇文章提出了一种新的单图像超分辨率扩散概率模型(SRDiff),以解决之前SISR模型中的过度平滑、模式崩溃和内存占用巨大问题。具体来说,1)为了提取LR图像中的图像信息,SRDiff利用预训练的低分辨率编码器将LR图像转换为隐藏的状态。2)为了生成以LR图像为条件的HR图像,SRDiff使用条件噪声预测器来迭代恢复x0。3)为了加快收敛和稳定训练,SRDiff引入了残差预测,在第一个扩散步骤中将HR和LR图像之间的差异作为输入x0,使SRDiff专注于恢复高频细节。SRDiff是第一个基于扩散的SR模型,有几个优点:

- Diverse and high-quality outputs: SRDiff 通过马尔可夫链将高斯噪声转换为SR预测,该链不会受到模式崩溃的影响,并且可以产生多样化和高质量的SR重新结果。

- Stable and efficient training with small footprint: 虽然HR图像的数据分布很难估计,但 SRDiff 使用变分界最大化的变体,并应用了残差预测。与GAN驱动的方法相比,SRDiff经过稳定的训练,只有一次损失,不需要任何额外模块(例如,仅用于训练的判别器)。与基于 Flow 的方法相比,SRDiff没有架构约束,因此受益于小的内存占用和快速训练。

- Flexible image manipulation: SRDiff可以使用扩散过程和反向过程执行灵活的图像操作,包括潜空间内插值和内容融合,这显示了广泛的应用前景。

我们对CelebA和DIV2K数据集的广泛实验表明,1)SRDiff可以在一个LR输入的情况下重建多个SR结果,并优于最先进的SISR方法;2)与SRFlow相比,SRDiff只有1/4的参数,训练稳定且快速(在1个GPU上大约30小时,直到收敛);3)可以在隐空间中操作生成的SR图像,以获得更多样化的输出。

Conclusion

这篇文章提出了SRDiff模型,这可能是第一个基于扩散模型的单图像超分辨率模型。

这篇工作利用马尔可夫链将HR图像转换为简单分布的 latents,然后在反向过程中生成SR预测,该过程使用基于LR编码器编码的LR信息的 noise predictor 迭代 denoise latents。

为了加快收敛速度和稳定训练,SRDiff引入了残差预测。

在人脸和普通数据集上的大量实验表明,SRDiff可以生成多样化和真实的SR图像,并避免了分别在psnr导向方法和gan驱动方法中出现的过平滑和模式崩溃问题。

此外,SRDiff训练是稳定的,模型小,没有额外的判别器。

此外,SRDiff 允许灵活的图像处理,包括潜空间插值和内容融合。

未来将进一步提高基于扩散的SISR模型的性能,加快推理速度。

未来还将把工作扩展到更多的图像恢复任务(例如,图像去噪、去模糊和去雾),以验证扩散模型在图像恢复领域的潜力。

-

Previous

【深度学习】Deep Tensor ADMM-Net:Deep Tensor ADMM-Net for Snapshot Compressive Imaging -

Next

【深度学习】BIRNAT:Recurrent Neural Networks for Snapshot Compressive Imaging